紅遍全球的聊天機器人 ChatGPT 開發商 OpenAI,18 日公布最新人工智慧安全指南,稱為「準備框架」(Preparedness Framework),由三個獨立安全團隊之一的準備團隊提出。

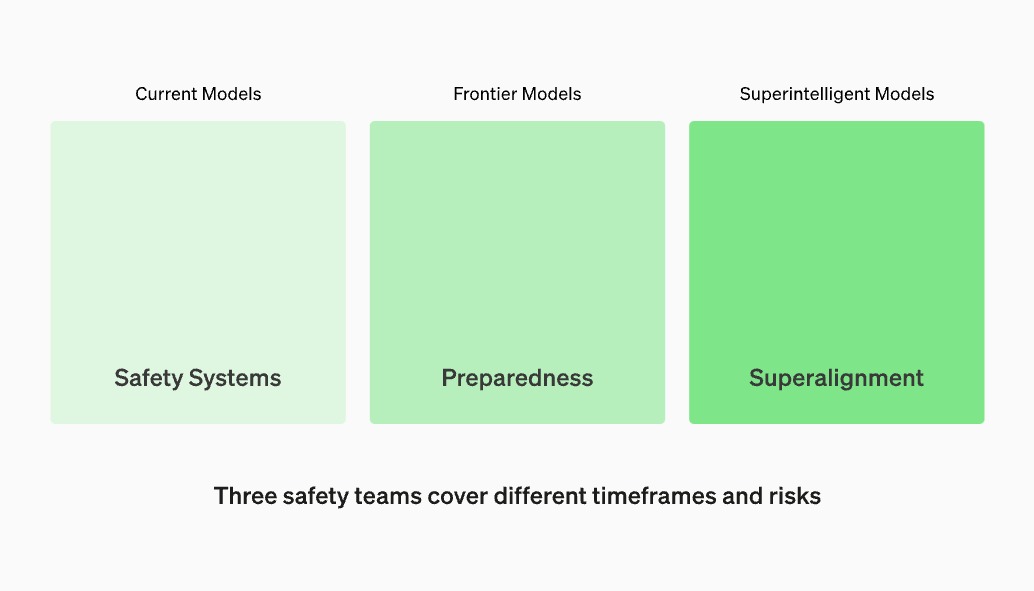

▲ Open AI 準備團隊研究尖端 AI 模型風險,安全系統團隊專注減少現有模型濫用,超級對齊(Superalignment)團隊旨在預防超越人類智慧的 AI 潛在威脅,三者共同努力降低人工智慧風險。(Source:OpenAI)

OpenAI 提出 AI 安全評估框架,防範災難性風險

綜合《華盛頓郵報》、《海峽時報》報導,準備團隊將評估尖端人工智慧系統可能「災難性風險」,框架災難性風險定義為「可能導致數千億美元經濟損失或許多人受嚴重傷害或死亡風險」。並據四個類別評分模型:

- 網路安全風險(Cybersecurity)

- 化生放核等大規模殺傷性武器(CBRN)

- AI 說服和欺騙人類的能力(Persuasion)

- AI S8 自主性(Model Autonomy)

▲ 準備框架對模型的評估記分卡。

董事會有權阻止新模型

OpenAI「準備」團隊由麻省理工學院 AI 教授 Aleksander Madry 領導,反覆評估 OpenAI 最先進的未發表 AI 模型,Open AI 僅能推出緩解後風險評級中或低的模型。OpenAI 還會聘請AI 研究員、電腦科學家、國家安全和政策專家組成安全諮詢小組,準備團隊向小組每月提交報告,小組則可建議公司領導層和董事會。

儘管 Open AI 執行長 Sam Altman 對是否推出 AI 模型有決定權,但董事會也有權推翻決定,延後發表 AI 模型。準備團隊還計畫定期安全演習,壓力測試,並允許合格獨立第三方審核。

準備團隊領導人 Madry 教授表示,希望其他公司也能使用 OpenAI 指南評估自家 AI 模型潛在風險。「我確實認為加速和減速框架極其簡單化。人工智慧有很多優點,但我們還需要努力確保優點實現,缺點不會實現。」

(本文由 動區動趨 授權轉載;首圖來源:Sam Altman)